기존 RNN( https://jw92.tistory.com/23 )의 문제점을 해결하기 위해 나온 것이 LSTM (Long Short-Term Memory)

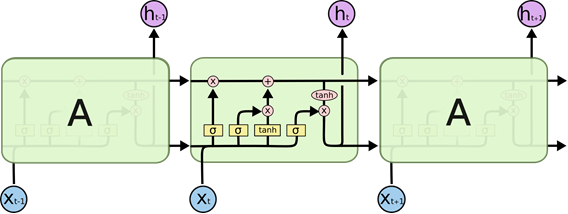

1. 구조

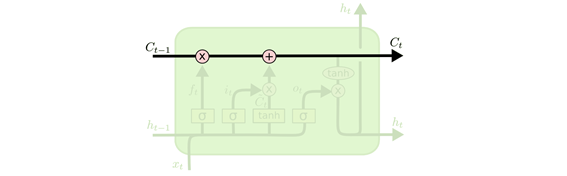

- LSTM의 핵심은 셀 스테이트(The cell state)

- 셀 스테이트는 아주 마이너한 계산을 거쳐 다음 셀로 이동, 이를 이용해 정보의 장기기억이 가능해짐

- 장기 기억과 단기 기억을 모두 고려

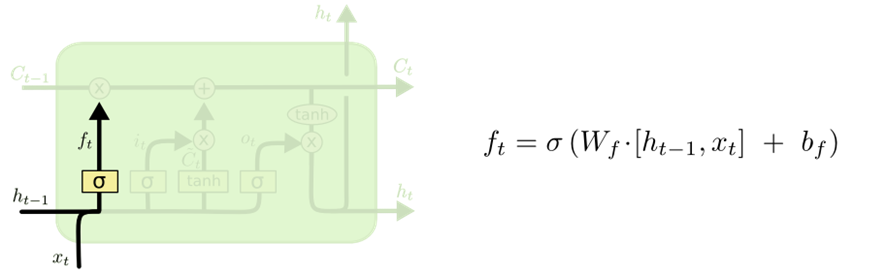

- forget gate layer에서 이전 시간에 있던 Input data의 영향력을 결정

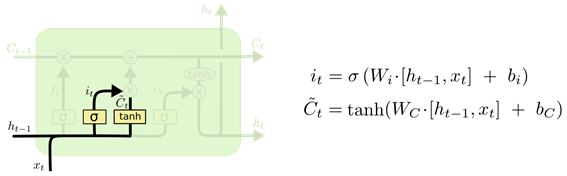

- Input gate layer에서 현재 시간 t에서 받은 Input data중 어떤 것을 cell state에 저장할 것인지를 정한다

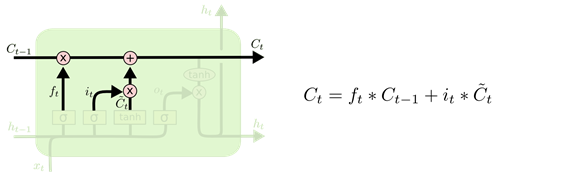

- Cell state 업데이트 (기존 정보를 잊어버리기로 했고, 그 대신 정보를 cell state에 더하는 과정)

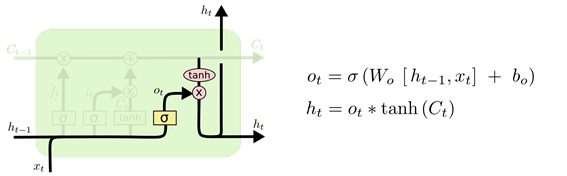

- Output gate layer 장기 기억과 단기 기억을 구분하기 위해 2개의 gate layer로 구분

2. 종류

활용 예)

one to many: Image captioning

many to one: spam detection

many to many: Translation

'AI' 카테고리의 다른 글

| Universal Transformer (2018) (0) | 2022.09.04 |

|---|---|

| LLM - Transformer (2017) (0) | 2022.09.04 |

| Attention Mechanism (Dot-Product Attention) (2015) (0) | 2022.09.04 |

| Seq2Seq (Encoder-Decoder Model) (2014) (0) | 2022.09.04 |

| RNN (Recurrent Neural Network) (0) | 2022.01.12 |